BTC/HKD+1.05%

BTC/HKD+1.05% ETH/HKD-1.29%

ETH/HKD-1.29% LTC/HKD-0.79%

LTC/HKD-0.79% ADA/HKD-4.15%

ADA/HKD-4.15% SOL/HKD+1.52%

SOL/HKD+1.52% XRP/HKD-1.71%

XRP/HKD-1.71%

作者|PietroCasella、PatrikLiuTran

翻譯|賈川、徐佳渝、楊婷

語言是人類最重要的發明,也是人類與其它物種的最大區別。語言使我們掌握了抽象推理,發展出了復雜思維,學會了與他人溝通交流。可以說,沒有語言就不會有現代文明。

因此,未來幾年大型語言模型將極大地影響生成式AI的發展,ChatGPT的迅速普及就是很好的例證。此外,LLM還在多種場景得到應用,比如內容創建、代碼生成、藥物開發、翻譯、搜索以及工作場所實用程序。

LLM應用實例

總之,生成式AI的最新進展標志著AI已然邁進新時代。AI如今不再只是研究課題,而是成為了幫助人們解決實際問題的實用工具,在各行各業發光發熱。因此,企業必須要重視AI的影響力。

面對AI的發展,企業要立即行動起來,維持自身競爭力。長期來看,未能與AI融合的公司將在這場競爭浪潮中日益落后,并逐漸消亡。對于企業來說,最關鍵的是要把控好AI的優勢和成本,采取必要措施將AI納入發展規劃。未來幾年將會是商業發展的黃金時期,新興企業已如雨后春筍般出現。

本文主要關注LLM,包括LLM和模型相關技術概述,以及它們在實踐中的應用。希望本文可以幫助從業者了解如何在業務中應用LLM,使行業潛在投資者全面了解這一領域,作出更好的投資決定。雖然我們提供的框架適用于所有生成式AI,但這里還是以LLM示例為主。

1

從Transformer到ChatGPT

AI領域常有開創性論文發表,這些論文影響著行業的未來發展方向。LLM領域中,“AttentionIsAllYouNeed”就是這樣一篇論文。

這篇文章由谷歌團隊于2017年發表,在文中,他們提出了一種名為Transformer架構,簡單來說,與當時的SOTA替代方案相比,Transformer架構具有高度并行性和計算效率,同時具有超高性能。

這意味著,采用Transformer架構的模型訓練成本更低、速度更快,生成的模型性能更好。在不影響性能的情況下,這種低成本、高效的組合十分重要,它能夠讓我們利用更多的數據,訓練更大的模型。

受Transformer啟發,在Transformer架構的基礎上,各類知名LLM層出不窮,例如:生成式預訓練Transformer模型、BERT以及XLNet。

有關GPT和BERT的論文最早可以追溯到2018年。次年發表了第一篇關于XLNet的論文。盡管如此,直到2022年底,OpenAI推出ChatGPT后,LLM才進入大眾視野,開始風靡于研究界之外。

ChatGPT推出后,不到一周的時間里,就收獲了超百萬用戶。這種普及速度十分罕見,幾乎超越了以前所有的科技產品。臺上十分鐘,臺下十年功,所有的突破性成就必然來自于夜以繼日的努力。基于GPT-3.5的ChatGPT是LLM領域多年以來的最重要的成就。實際上,ChatGPT的基礎模型并不是最好的LLM,但卻是目前最受歡迎的模型。

時間會證明一切。在我們看來,ChatGPT最重要的是作為PoC(為觀點提供證據),向世界展示LLM的能力。盡管ChatGPT發布初期十分火爆,但我們不確定它能否成為主流LLM之一,在實際用例中獲得廣泛應用。原因如下:

2

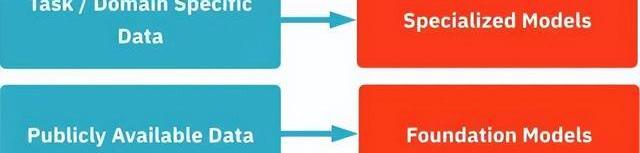

基礎模型vs專用模型

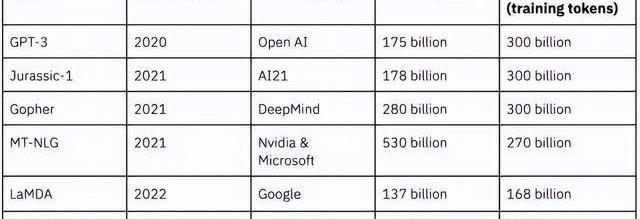

基礎大型語言模型是在大量公開文本、數據上進行訓練的。模型訓練數據話題廣泛,內容繁雜,并不針對特定領域和任務,這類模型包括:GPT-3,Jurassic-1,Gopher和MT-NLG。

目前,雖然建立在基礎AI模型之上的應用程序非常流行,但我們預計,專用于特定領域或任務的模型才能發揮出LLM的真正價值。因為與相同模型大小的基礎模型相比,在專業領域里,專用模型的表現通常來說更好。這意味著,我們需要用更大的基礎模型才有可能在專業領域實現與專業模型相同的性能。

專用模型比基礎模型表現更好的原因之一與模型對齊有關,即LLM的輸出與模型用戶的目標和興趣相對應的程度。更好的模型對齊意味著答案是正確且相關的,也就是說正確回答了模型請求的問題。由于專用模型僅關注特定領域或任務,因此與基礎模型相比,專用領域模型的對齊程度通常更高。

Moonbirds:4月18日啟動Diamond Nest“Choice Pass”空投:金色財經報道,NFT項目Moonbirds在社交媒體宣布將于4月27日啟動獨家Diamond Exhibition NFT投放,屆時將展示22位藝術家的1萬件數字藝術品,包括Beeple、Greylesian、Dirty Robot等。此外,Moonbirds還宣布將在4月18日啟動Diamond Nest“Choice Pass”空投,4月24-27日,Choice Pass持有者可以選擇自己關注的藝術家,后續Choice Pass持有者的抽獎和空投將于4月27日進行。[2023/4/8 13:51:27]

我們有多種方式實現模型的專用化,其中之一就是利用專用領域或任務的數據來訓練基礎模型。比如,一個基礎模型可以很好地回答銀行相關的一般問題,然而,如果你想要打造一個專門針對銀行的聊天機器人,那么這個通用模型的性能水平就不太夠用了。這時,我們就可以利用銀行業相關的數據集來訓練這個模型,實現模型專業化。反過來,假如有一家銀行想要在客服服務中應用聊天機器人,從而實現簡單任務的自動化,此時銀行可能會在實際客戶服務對話的專門數據上進一步訓練這個專業模型。像這樣訓練以后,LLM就能學會特定銀行按照一定政策的行事方式,畢竟不同銀行可能有不同的政策和指導方針。

因為專用模型針對的是特定任務,不涉及其它不相關的領域和任務,所以說,不需要用到很大的基礎模型來進行進一步訓練。使用更小的模型意味著更低的推理成本和更小的內存占用,也就是說,比最大的可用模型小得多的基礎模型可能會成為專用基礎模型的首選。

3

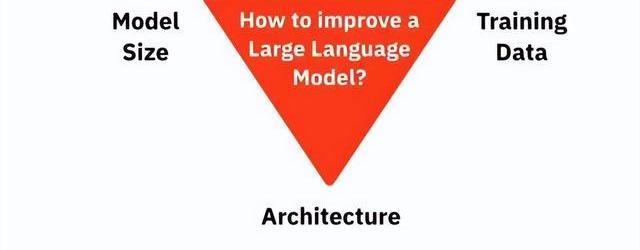

LLM如何改進?

為了更好地了解LLM的功能和局限性,我們首先要了解該如何改進它們。LLM的改進有三個主要驅動因素,分別是:體系結構改進、更大的模型、更多的訓練數據。接下來我們將對這三方面進行逐一介紹。

架構改進是關鍵,但很難取得突破

架構改進可以在不增加模型復雜度和訓練數據量的情況下提升LLM性能。目前正在構建的多數SOTA性能LLM仍然是基于Transformer的網絡架構。盡管它具有已知的局限性,但目前還沒有廣受認可的架構更新。話雖如此,人們一直在不斷探索,試圖改進架構,并為此推出了所謂的高效Transformers來消除已知局限。

對現有SOTA架構的漸進式改進將逐年突破模型性能界限。此外,每隔一段時間,行業就會迎來突破性的架構改進,這些改進代表著模型性能的跨越式提升。

與增加模型大小和訓練數據量相比,改進模型架構較為困難。模型架構改進遵循傳統研發模式,需要大膽創新,且無法保證結果,因此,LLM的此類性能改進最為棘手,同時也是架構漸進式提升與突破向社區發布和分享的標準。除了率先使用先進模型,這意味著這類提升不能作為長期優勢去與其它構建LLM的公司或對手競爭。例如,OpenAI的LLM是以GoogleBrain2017年發明并公開的Transformer為基礎。

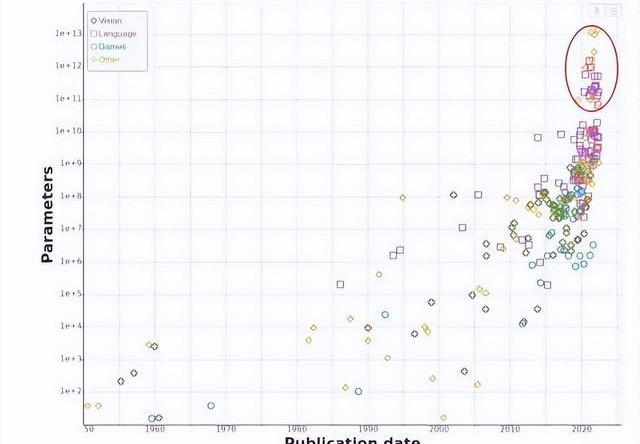

LLM改進經典做法:擴大模型規模

目前,為了提高LLM性能,人們將大部分精力放在了增加模型大小上面。2020年,OpenAI發表了一篇論文,提出了在增加模型尺寸與提高模型性能之間的擴展定律,論文的結論是:人們應該將大部分預算用于擴大模型規模。這篇論文直接推動了增大模型規模的浪潮。下圖出自論文MachineLearningModelSizesandtheParameterGap,圖中顯示近年來語言模型大小呈顯著增長趨勢。

2019年之前,大多數LLM的參數都在數億級。2019年,OpenAI發布了有15億參數的GPT-2。2020年,谷歌和微軟發布了T5和TuringNLG,分別包含110億和170億個參數。2020年年中,OpenAI發布了1750億個參數的GPT-3。從那時起,大型模型開始接連出現,例如AI21的Jurassic-1、DeepMind的Gopher、Nvidia和微軟的MT-NLG以及北京智源研究院的WuDao2.0。

LLM之所以可以通過增加模型規模來提升性能,是因為這樣做能提升模型對復雜現實的建模能力。由于Transformer架構速度快、性價比高,一直是訓練大型模型的首選。然而,在同等條件下,更大的模型也意味著更高的訓練和推理成本,同時也意味著更大的內存占用,也就是說,模型需要部署在更大的硬件上。因此,在預算和內存有限的情況下,盲目擴大模型規模并不是提升模型性能的最佳選擇。

Coinbase NFT:暫停“creator Drops”,不會關閉NFT市場:金色財經報道,加密貨幣交易所 Coinbase 的 NFT 平臺 Coinbase NFT 周三表示,它正在暫停“creator Drops”,以將其精力集中在其市場的其他方面。Coinbase NFT 表示,“我們正在暫停 NFT 市場上的創作者 Drops,以專注于創作者要求的其他功能和工具,但需要明確的是:我們不會關閉 Coinbase NFT 市場。”

周三下午,Coinbase NFT 合作伙伴Jessica Yatrofsky表示,她即將推出的 NFT 系列將不再出現在 Coinbase NFT 上,并表示她已“私下獲悉NFT市場正在關閉。”Coinbase NFT 迅速回應了謠言,表示他們確實正在暫停“creator Drops”以專注于改進,但他們并沒有關閉 NFT 市場。[2023/2/2 11:42:16]

大規模訓練數據集的競賽

一直以來,人們都低估了訓練數據在模型性能提升方面的重要性,這種重要性包括質量和數量兩方面。2022年DeepMind團隊發表了一篇論文,文中對比了模型大小和訓練數據,最終結論是:多數語言模型明顯訓練不足。也就是說,在不增加模型大小的情況下,在更大的數據集上訓練模型將受益匪淺。

文中,DeepMind團隊訓練了一個相對較小的LLM,名為Chinchilla,這個模型只有700億個參數,但卻有1.4萬億個訓練token。經過訓練,Chinchilla模型的性能超越了諸如GPT3、Gopher、Jurassic-1和MT-NLG等更大的語言模型,這些語言模型的參數都在1750億-5300億之間,但訓練token卻在2700億-3000億之間。這表明為了提升模型性能,人們必將打響訓練數據集之戰。

此外,我們還可以通過強化學習來利用更多數據,提升LLM的性能。2017年,OpenAI發布了一類新的強化學習算法:近端策略優化,是目前行業里的SOTA。在實踐中,近端策略優化操作更為簡單,并且它的表現能夠達到甚至超越其它替代方法。

ChatGPT背后的LLM已經利用人類反饋的強化學習實現了微調,步驟如下:第一步:通過監督學習,用人類對不同提示的“理想”回答數據微調LLM。第二步:LLM為每個提示提供多個答案,然后由人工對這些答案進行排名。第三步:用近端策略優化模型來優化LLM的獎勵模型。強化學習可以引導模型提供更加正確、公正、有益的答案。總之,現在的LLM更加強大。

事實上,這也是OpenAI將ChatGPT發布為“免費試用”的主要原因之一。ChatGPT生成的每個回答旁邊都有一個“贊”和一個“踩”按鈕,用戶可以通過這兩個按鈕來評價模型生成的回答。無論是“贊”還是“踩”都會出現一個對話框,用戶可以將理想答案輸入框中,而這些答案正是強化學習第一步需要的數據。

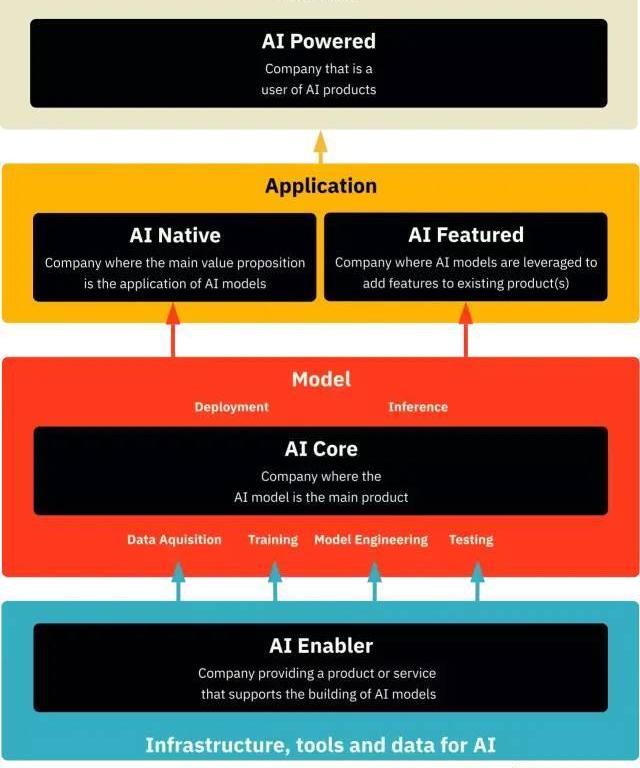

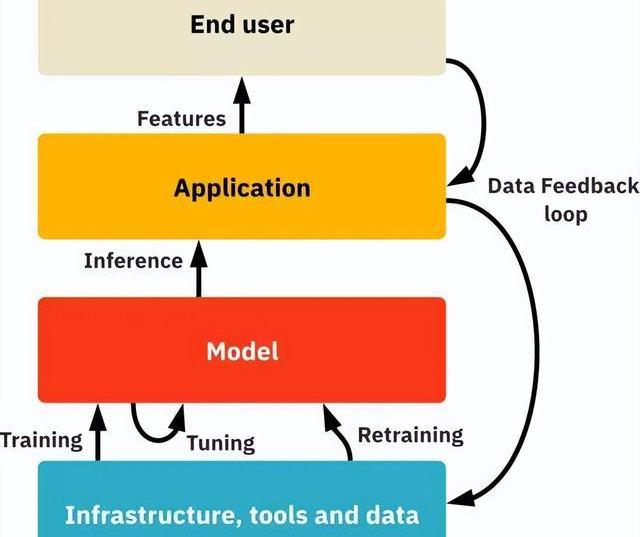

人工智能技術堆棧

AI賦能公司主要在AI技術堆棧的底層,為構建AI模型提供基礎設施、工具和數據支持。AI內核公司的主要業務是構建和銷售AI模型,在構建模型的過程中,AI賦能公司為其提供相應支持,以完成數據獲取、模型訓練、模型工程和模型測試等任務。

AI原生和AI特色公司處于應用層,它們使用的都是AI內核公司提供的AI模型。不過也有一定區別,AI原生公司的產品或服務的內核價值來自于AI模型的應用,而AI特色公司則是利用AI模型為已有產品添加新的功能。AI驅動公司則處于AI技術堆棧的頂層,也就是最終用戶所在的層級。

1.AI賦能公司:為AI模型構建提供所需基礎設施、工具及數據

AI賦能公司是一類專為構建AI模型提供必要技術的公司。由于生成式AI模型具有巨大的參數集,因此確保可靠的基礎設施以支持處理工作負載至關重要。此外,還需要提供MLOps工具,以協助模型構建。在AI賦能公司中,提供訓練數據、獲取數據相關工具的公司最為引人注目,因為數據是影響模型性能和差異化的重要因素。

從基礎設施開始

在LLM領域,大多數LLM在模型的訓練和部署方面高度依賴云服務提供商。三大主要云服務提供商都有一些在該領域中具有重要地位的客戶。例如,OpenAI正在使用微軟Azure平臺,DeepMind使用的是谷歌Cloud平臺,StabilityAI則選擇了亞馬遜AWS作為其主要的云服務提供商。

英國央行正為“CBDC樣本錢包概念證明”項目進行招標:12月12日消息,據外媒報道,英國央行(BOE)在英國政府數字市場官方發布了“CBDC樣本錢包概念證明”項目招標申請,預算范圍為20萬英鎊。項目周期為5個月,申請將于12月23日截止。

該項目概述了概念驗證錢包必須實現的簡單指導原則,該錢包似乎只需要提供基本功能,如注冊流程、更新詳細信息的方法、顯示余額和交易以及顯示通知等其他要求。該錢包還必須證明它可以使用CBDC加載和卸載商業銀行的資金,并且能夠通過帳戶ID或QR碼請求點對點支付,并且可以用于與企業在線支付。該項目的主要交付成果是創建一個適用于iOS和Android的移動應用程序、一個錢包網站和一個示例商戶網站和后端基礎設施,為錢包網站和應用程序提供服務,同時存儲用戶數據和交易歷史。(Cointelegraph)[2022/12/12 21:38:56]

隨著LLM的興起,人們對云服務提供商所提供的存儲和計算服務需求不斷增加。如果將LLM的興起看作是一場持續的淘金熱,那么云計算和存儲服務提供商就像是這片土地的所有者,人們則是涌向這片土地的淘金者。為了成為計算和存儲方面的首選提供商,云服務提供商會盡可能地為LLM的開發者提供最佳服務,這是一個明智的決策。

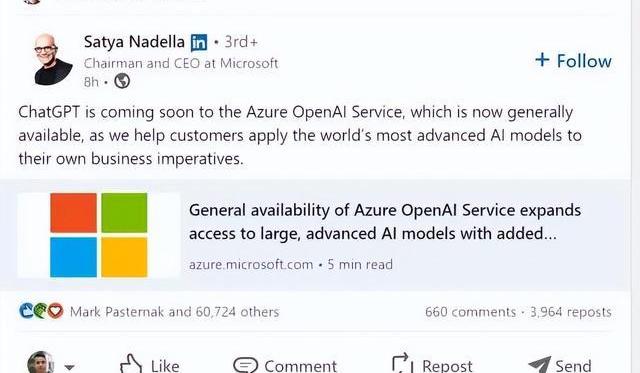

云服務提供商將成為重要的分銷渠道,例如它們會通過自己的云市場來銷售產品和服務,以方便以上云客戶使用這些模型。最近,微軟的首席執行官SatyaNadella透露,他們將通過AzureOpenAI服務向用戶提供ChatGPT模型。我們相信,未來會有更多這樣的例子出現。

要想成為有競爭力的云提供商,需要關注多個因素,包括模型訓練和運行推理的速度及成本。例如,CerebrasSystems專注于為深度學習應用程序提供計算服務,旨在降低深度學習應用程序的訓練和推理成本,并將計算速度提高到普通替代方案的十倍。

由于模型的大小、架構以及訓練數據量的不同,訓練成本可能會高達數千萬美元,訓練時間會長達數百天。因此,節約成本和時間仍將是未來深度學習領域的重要因素。有趣的是,我們看到一些區塊鏈公司正在將其硬件重新用于AI模型訓練和推理,這一轉變有望加速新參與者進入該領域。

便利性和易用性也是云服務提供商需要考慮的另一重要因素。云服務提供商可以通過優化底層硬件來訓練一般的深度學習模型及特殊的深度學習模型,無需用戶進行大量的手動調整。

此外,訓練大型語言模型需要大規模的計算集群,而租用這些計算集群通常需要簽訂多年的合同,這種方式對于消費者來說缺乏靈活性。因此,提供更加靈活的短期租賃方式對消費者來說更具吸引力。

用于模型工程、開發和測試的工具

MLOps是一種將機器學習模型整合到軟件開發周期中的實踐和流程,旨在讓機器學習模型在生產環境中保持高性能和高可靠性。對于LLM來說,這涉及到模型工程、開發和測試。

在模型工程和開發階段,機器學習研究人員和工程師通常使用像TensorFlow、PyTorch這樣的庫和框架。在模型開發完成后,需要對模型進行測試,然后再部署模型。

LLM模型與其他機器學習模型一樣,都能對訓練數據中的信息進行編碼,并在推理階段對信息進行解碼。然而,由于其訓練數據主要是人類的書面對話和文本,因此可能存在偏見。大家可能都還記得,微軟推出的一款聊天機器人Tay,該機器人是通過Twitter數據進行訓練的。然而,幾個小時后,該機器人就開始發表帶有種族主義色彩的言論。

此外,互聯網中存在著大量的錯誤信息,我們從中收集了大量LLM模型所需的訓練數據。如果不對訓練數據進行質量驗證,模型就可能受到錯誤信息和人類偏見的影響。

目前,還沒有一個可擴展、自動化的企業生態系統,能夠監控和驗證文本形式的非結構化數據的質量和有效性。隨著LLM服務越來越受歡迎,為了滿足人們對此類服務的需求,我們當然需要采取一些自動化的方法來執行這些任務。因此,我們預計在未來這一領域會有很多的可能性。甚至可能會出現專注于評估文本數據質量及有效性的LLM模型。

在模型測試方面,有許多人們廣泛接受的基準可用于評估LLM的性能。其中一個例子是斯坦福大學的一組研究人員提供的全面評估語言模型。HELM是一種全面評估LLM性能的基準,它涵蓋了多個方面的指標,如準確性、校準性、魯棒性、公平性、偏見、有害性和效率。盡管如此,HELM仍不能完全反映出實際語言模型性能的全貌。據多次報道,在基準測試上表現良好的模型,在實際測試中可能會表現不佳。

英特爾推出支持NFT鑄造的芯片并成立“Custom Compute Group”新部門:金色財經報道,2 月 25日,據NFTPLAZAS報道,芯片制造科技巨頭英特爾正在推出一款全新芯片,該芯片設計除了讓加密貨幣(主要是BTC)開采過程更輕松之外,還將支持NFT鑄造。據悉,這款芯片將會在今年晚些時候發貨,而Jack Dorsey旗下區塊鏈公司Block(前身為支付公司Square)是該芯片的首批消費者。此外,為了擴大在 NFT 和加密行業的影響力,英特爾公司將會在旗下加速計算系統和圖形業務組織內成立一個自定義計算新部門“Custom Compute Group”。[2022/2/25 10:15:44]

OpenAI產品負責人FrasherKelton在一篇博客文章中提供了一個很好的例子,該例子表明當模型在某個任務上表現更好時,可能在另一個任務上表現更差。此外,在實際應用中,除了準確性、公平性、有害性等指標,推理成本和延遲也是非常重要的度量標準,需要與其他指標一起進行權衡和綜合考慮。

鑒于此,Kelton提出了一種更理想的測試方法,即需要通過不斷地試錯和探索來判斷模型是否適合推向生產環境。然而,這種方法并不理想。因此,我們可能會看到在這個領域中會出現幾家大公司,來提供更完善和可信的解決方案。

數據采集

數據采集的第一步通常是獲取大量的文本數據集。最初的數據集通常來自于免費開放數據源,這些數據可以在模型中心中找到。它們可能包含成千上萬個數據集,每個數據集包含數百萬甚至數十億個單詞。如果用戶條款允許,你還可以通過爬取網站和應用程序來獲取文本數據。一些潛在的有趣數據來源有維基百科、博客文章、論壇、Linkedin和Twitter。

除了免費開放數據源外,大多數LLM構建者仍然會收集額外的數據。此處,我們強調了三種主要的數據采集策略:數據標注、合成數據生成和通過反饋循環進行數據收集。

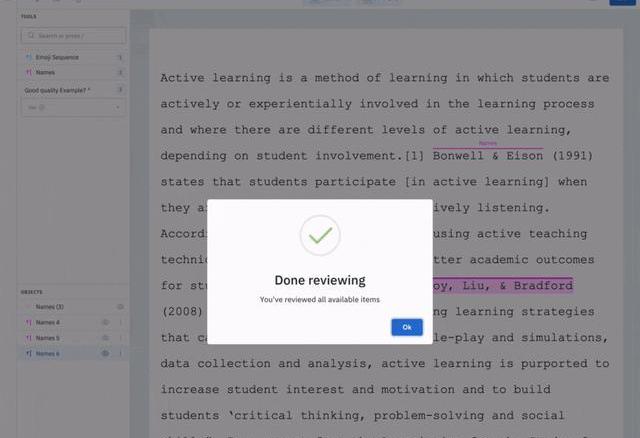

以數據標注公司ScaleAI和Labelbox為例,它們提供了高效的數據標注工具。此外,推薦一個免費的開源替代品Labelstudio。我們預測,未來標注技術提供商將整合LLM,為用戶提供標簽。這樣,用戶只需要核對和批準這些標簽,無需從頭開始實際標注。最耗時的標注任務將被自動完成,從而提高了標注效率,使得標注數據的數量呈指數級增長。

使用Labelstudio可以輕松標記新數據

合成數據指的是生成人工數據的過程。其中,最常見的用例是當你因隱私保護而不能使用真實的原始數據時,你要么放棄數據,要么想出一些巧妙的方法對數據進行匿名化,同時仍然保留感興趣的信息。如果你選擇后者,就需要使用合成數據。Mostly和Hazy是該領域的兩個例子。

如上文“更多訓練數據競賽”一節所述,基于人類反饋的強化學習可以顯著提升模型性能。然而,要執行強化學習,需要一定類型的訓練數據。例如,在第一步中,需要為不同的prompt提供所需的答案。這些數據與所使用的模型無關,可以由第三方數據供應商提供。

接下來,人類需要對基于某一prompt生成的不同答案進行排序,這一步取決于所使用的模型,并且需要有人對想改進的實際模型的答案進行排名。因此,未來可能會出現一些公司,它們會提供第一步所需的數據集,并為第二步提供咨詢服務。

此外,還將涌現出一些工具,以簡化收集和提供此類訓練數據的過程。如果你想大規模收集此類數據,那么就需要使用簡化數據收集和處理過程的相關工具。Humanloop公司則提供了一種軟件開發工具包,可以從用戶那里獲取AI的答案反饋。

我們可以在ChatGPT和Jasper中觀察到這些反饋循環的具體例子。如前文所述,ChatGPT允許用戶提供“贊”或“踩”作為生成答案的反饋。相比之下,Jasper提供了更多的反饋細節和選項,讓用戶可以對文本進行贊、踩、標記收藏、刪除或編輯修改。編輯后的文本可以顯示出理想答案的特點。

OpenAI、Cohere和AI21的API測試平臺對比

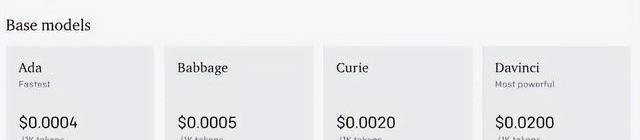

AI內核公司可以選擇對模型閉源或開源。閉源公司通常用API來隱藏其模型以保護它們。目前,閉源公司通常會按API調用次數向客戶收取費用。

以下是OpenAI關于GPT-3的定價截圖,由于所需模型的性能水平不同,API調用的成本也會不同,使用性能較好的模型比使用性能較基礎的模型昂貴。此外,還存在推理速度上的差異,以滿足你對各種用例的時延需求。換句話說,你可以根據自身的實際需求選擇適合的LLM性能水平,并在相關成本和性能之間取得平衡。

三箭資本CEO談“CeFi與DeFi”:極端辯證法不可取 中間路徑才是王道:Three Arrows Capital(三箭資本)首席執行官Su Zhu在推特上發表個人對“CeFi v DeFi”的看法稱:“在加密領域中,人們經常陷入極端的辯證法(這個會扼殺那個,或者這就是2.0);但現實往往是中間的路徑。我非常有信心,大部分目前被認為是金融科技或傳統金融的東西將會隨著時間的推移而過時;然而,在這一領域最聰明的行動者會在為時已晚之前合并、采用或加入。”[2020/7/19]

OpenAI的定價模式

像Jasper這樣的公司,開始會在一個由AI內核公司構建的閉源LLM上構建他們的整個產品,這意味著他們沒有實際的LLM知識產權。這是這些公司面臨的主要風險之一,因為這使他們無法控制模型,無法根據自己的需求進行專業化改進。此外,閉源模型通常比你可以自己托管的開源替代方案更加昂貴。

開源模型的AI內核公司則不會有這些擔憂。即使他們提供了LLM模型代碼,許多公司也沒有能力以強大、可擴展的方式將LLM模型投入生產并提供服務。因此,開源提供商通常通過模型托管服務來獲取收益。當前,一些組織致力于構建開源LLM模型,例如Eleuther、Together和BigScience/Huggingface等等。值得一提的是,谷歌和Meta已決定開源其中的許多模型。

目前,大多數AI內核公司提供的是通用基礎模型。根據我們在“基礎模型vs專業模型”一節中的預測,LLM模型的最大價值將來自于專用化的模型。

因此,對于AI內核公司而言,他們可以提供基礎模型,然后讓客戶使用自己的數據來訓練這些模型,從而得到在特定領域表現更好的、專門針對客戶需求的專用化模型。這項服務將成為AI內核公司的一個重要的收入來源。AI內核公司還將提供越來越多的專用化模型,AlphaFold就是一個典型的例子,它專注于蛋白質結構領域。

3.AI原生和AI特色公司打造具有良好用戶體驗的AI應用

需要注意的是,使用LLM模型的大多數用戶并非AI專家。因此,僅提供LLM模型的API并不能幫助他們解決任何問題,這就是為什么用戶體驗非常重要的原因。

隨著基礎AI模型的日益普及和專用化模型的開發越來越簡單,用戶體驗的重要性將會進一步提高。因此,在用戶體驗層面的差異將變得更加關鍵。

Jasper的發展歷程是一個極好的例子,展現了用戶體驗的重要性。該公司成立僅18個月后在A輪融資中籌集了1.25億美元,估值達到了15億美元,當時他們吸引了將近10萬付費客戶,年收入達到7500萬美元左右。

Jasper最初沒有自行構建任何LLM模型,而是選擇了利用OpenAI的GPT-3作為基礎,通過API接口構建出用戶體驗更好的應用。換句話說,他們更加注重開發易于使用和吸引人的應用,而不是自行構建LLM模型。在設計過程中,他們考慮了一些關鍵問題:

GPT-3API的prompt輸入應該是什么樣的?

輸出應該如何呈現?應該呈現多少條輸出建議?

用戶存儲和排名不同的備選方案是否易于操作?

這個工具如何融入文案撰寫的整個工作流程中?

雖然Jasper.ai和競爭對手Copy.ai幾乎是在同一時間使用OpenAIGPT-3API構建其應用程序,但是Copy.ai在最終用戶中的影響力遠不如Jasper.ai。造成這種差異的因素可能有很多,其中用戶體驗是一個關鍵因素。

一個需要考慮的重要問題是:用戶體驗層與底層的LLM之間能有多大的獨立性?在更改應用程序的底層LLM時,是否可以避免對用戶體驗產生負面影響?對于LLM的漸進改進,用戶體驗層通常不會出現太多負面影響。

然而,對于LLM的重大變革,后果可能會更大。例如,大多數LLM目前只會從用戶提示中獲取信息并返回答案。因此,使用澄清問題來增加答案的相關性,將有助于提高模型的準確性。可以說,那些構建在LLM之上的公司正在創造出良好的用戶體驗來彌補底層模型的不足之處。

實際上,GPT-3不會詢問澄清問題,也不能一直提供完美的答案。因此像Jasper這樣的公司就應運而生,他們可以提供多個答案,并允許用戶輕松修改答案并對其進行排名以彌補缺陷。然而,當缺陷直接在底層的LLM中被修復時,這些公司必須尋找其他方式在應用程序層面提供價值,以保持他們在行業中的競爭地位。

根據AI模型對產品價值主張的重要程度,我們可以將應用程序層面的公司分為兩類:AI原生公司和AI特色公司。

AI原生公司:將AI模型作為產品核心價值主張

AI原生公司指的是那些價值主張完全基于應用AI模型的公司。這類公司自己不創建AI模型,而是利用商業版的GPT、GoogleT5和Anthropic以獲得成本和性能方面的優勢。前面提到的Jasper.ai和Elicit.org都屬于這類公司。

Elicit.org的研究搜索引擎

人們就AI原生公司的護城河展開了激烈的辯論,爭議點在于:如果公司“僅”在他人AI模型的基礎上提供擁有出色用戶體驗的UI,那么公司的業務護城河究竟如何?

假如ChatGPT已經存在,那么成立像Jasper.ai和copy.ai這樣的公司又是否可行?無論答案如何,就目前情況而言,幾個AI原生公司已迅速獲得了大量客戶,同時籌集到大量資金。有了資金保障,這些公司就能招募團隊,自己構建基礎模型,深入研究技術并實現真正擁有模型。速度和創新對于這類公司至關重要:雖然它們可以通過依賴他人的LLM迅速開啟自己的事業,但也需要快速適應才能存活下來。

AI特色公司:利用AI模型來改進現有產品

AI特色公司將AI模型與現有產品相結合,以創建附加功能。對于這類公司而言,AI功能并不是其產品的核心。

生產力工具Notion就是一個很好的例子。Notion本是一個記事工具,但最近添加了一個快捷方式,用于通過prompt生成文本。雖然這不是Notion的核心功能,但對于其用戶來說,卻是一個很有價值的補充功能,因為這使得用戶可以直接在Notion中生成文本,而不用在其他地方生成好再復制粘貼過來。

Notion新的AI功能

GoogleDocs也利用AI模型來提供自動完成功能。雖然GoogleDocs的主要價值主張與自動完成功能無關,但該功能提高了用戶的生產力,因而得到高度好評。Canva也是一樣。Canva本是一個用于創建演示文稿的工具,但通過利用AI模型,演示文稿的文本和圖形都可以根據用戶的prompt和反饋來自動生成。

上述例子表明:用戶體驗是否出色對于AI模型的成功至關重要。那么如何利用LLM來提供出色的用戶體驗?關鍵點在于將AI模型深度集成到你想用LLM所解決任務的現有工作流程中。這也是目前這類公司中成功案例的標準做法。因此,預計將來還有很多AI特色公司都將成為各自領域的贏家。

話雖如此,但也有很多公司將AI功能集成到其產品后,并未給其用戶帶來多少額外價值。這些公司可能只是為了趕生成式AI的熱潮。因此,區分哪些公司的AI特性能夠真正提升用戶價值十分重要。

4.AI驅動公司:智能公司和增強人類生產力

AI驅動類的公司消費AI產品但不提供任何AI應用程序或AI模型。這是目前市面上數量最為龐大的群體,預計在不久的將來,所以公司都將成為AI驅動公司,其大多數產品和服務都將包含某種AI功能。這個過程一般需要兩步:

第一步,公司內部某些員工會根據自己的需求來利用AI產品提高工作效率。例如,營銷經理可能會使用Jasper或ChatGPT來編寫文案,而客戶主管則可以利用LLM為潛在客戶定制電子郵件。

第二步,AI產品的利用方式更加系統化。此時AI產品的使用范圍不再局限于公司內部個別員工,高層管理人員也開始使用AI來制定戰略政策。公司也由此轉型為“智能公司”。例如,BuzzFeed在裁員12%后,其首席執行官JonahPeretti計劃使用AI來編輯文章和協助商業運營操作。他預計AI的加入將會在短期內提升員工的生產力,并且在15年后,AI則能夠自主生產內容并提供個性化服務。在該消息發出后的一個交易日內,BuzzFeed的股價就上漲了超150%。

AI能提高智能公司的自動化程度。上一個自動化時代主要圍繞機器人流程自動化展開,整個過程按照人類主導的基于規則的腳本來展開。而新時代的自動化一般將圍繞生成式AI來運作,尤其是LLM。

使用LLM時,我們能夠超越基于規則的腳本,自動化更多異構任務,而不必給出明確指令。這些任務包括但不限于欺詐檢測、簡化客戶服務任務、內容生成、會議轉錄、會議總結、法律文件分析等。

此外,LLM還將在構思、討論、解決問題和決策過程等多方面提高公司員工的能力。這種能力也將自然地集成到公司使用的日常工具中,如Slack、Zoom和Notion。換言之,LLM能傾聽對話并適時作出貢獻。如果權限夠大,LLM還能存儲公司所有溝通內容,從而打破耗時且成本高昂的知識孤島。

目前仍有許多公司尚不清楚生成式AI會對其未來發展帶來多大影響。實際上,大多數公司都應該認真思考是否應該利用AI以及如何利用AI來提高生產力。因為在完善服務、提高質量以及控制成本方面,這可能就是拉開差距的地方。

5.AI技術全棧公司

雖然我們根據AI公司在技術棧的哪個部分集中投入最多來將其分類,但實際情況并不總是那么黑白分明。無論類別如何,AI公司通常都需要與整個技術棧進行互動和協作。

首先,AI賦能公司提供訓練數據,AI內核公司用這些數據來訓練LLM,然后AI原生或AI特色公司使用LLM來開發應用程序。

如上文所述,應用層的公司有大量機會來收集用戶反饋數據,而這正是強化學習LLM所需的數據類型。換句話說,應用層的公司通常既是應用程序提供者,也是數據提供者。要擁有從數據到應用層的整個技術棧,它們唯一缺失的部分就是模型層。實際上,Jasper.ai最近宣布開始構建自己的LLM,這將使他們擁有從數據到應用層的整個價值鏈。

同樣,OpenAI最開始在模型層,隨著ChatGPT的推出,他們進入了應用層,通過收集人類反饋訓練數據,他們現在已經能夠進入數據層。換言之,他們也開始擁有整個AI技術棧的價值鏈。在未來,這樣的例子將會越來越多。

5

未來發展

希望這篇文章能使你對生成式AI和LLM有個大致了解。不過,我們現在仍處于這個新時代的早期階段,未來幾年的進展甚至會超過前幾十年的的累積之和。以下是值得進一步探討的八個問題:

1.生成式AI的淘金時代:繼2022年高度關注Web3和加密貨幣后,投資者和企業家已經將重心大量轉向了AI,尤其是生成式AI。現在已有大量資本進入該領域,這不由得使我們想起了2021年,心中自然而然生出一個問題:這會不會又是一場沒有結果的炒作?

自1956年AI誕生以來,AI領域就一直擔負著人類很高的期望。每當這些期望無法被滿足時,AI就一次次進入了“寒冬”。但隨著生成式AI的不斷發展,這樣的日子已經一去不復返了。在恰當用例上,AI可以提供巨大的價值。然而,由于一些投資者在不了解情況下盲目投資,導致估值虛高,因此該領域可能會出現過熱現象。話雖如此,我們始終堅信AI的黃金時代已然到來。

2.智能組織和增強員工生產力:如上所述,AI驅動公司將使用AI增強來實現任務自動化和改善決策能力,以此來提高生產力。有研究報告指出:GithubCopilot可以使開發速度提高55%,這意味著通過利用AI模型,開發人員的生產力將顯著提高。這很可能只是個開始,LLM在代碼生成方面會變得越來越好,甚至開發人員可能進入無代碼時代。

就其他領域而言,比如法律、市場營銷、銷售、客戶服務,也有望以類似的方法提高生產力。最終每個行業中的每個公司都將思考:這對我們意味著什么?在這場革命中,每個公司只能選擇加入或者被加入。

3.專用模型的崛起:預計大部分價值將來自于專業模型而非基礎模型。因此,未來我們將會看到越來越多的專用模型,比如用于銀行客戶服務的模型就不需知道如何以說唱風寫詩歌,而且還可以為個人任務或所屬領域而打造更小的專屬模型。

我們預測:實際上對于像OpenAI、AI21和Cohere這樣的AI內核公司來說,開發出能讓客戶在他們基礎模型上輕松創造出專業化模型的功能至關重要,因為所有人都在期待該功能,以解鎖LLM的下一個價值級別。

除了通過專用模型實現卓越性能外,應用層的公司還將獲得一種私有模型,使得這類公司不僅是建立在基礎AI模型之上的不錯UX。

4.多模態模型:雖然本文主要關注語言模型和文本數據,但生成式AI還包含其他模態,例如圖像和聲音。近來,人們正努力將不同模式組合到AI模型中,打造具備多模態輸入輸出能力的模型。最近,GoogleResearch團隊發表了一篇論文,展示了如何將文本轉化成音樂。這種模型本身就很強大,有了這種模型,沒有音樂背景的人能夠通過自然語言描述,生成音樂。但試想一下,如果我們將這種模型與圖像轉文本能力相結合,會怎么樣呢?這意味著我們可以利用AI分析視頻內容,生成描述性本文,最后由AI配上合適的音樂。另外,我們還可以反過來操作,如果已經根據文字提示生成了音樂,現在我們還可以用AI來生成相應視頻。要做到以上這些,我們只需要向多模態模型發出一條指令。

黃仁勛是英偉達的創始人兼首席執行官,他曾于2023年1月訪問瑞典,在那期間,我們曾與他討論英偉達在生成式人工智能領域的重點。他提到英偉達不再像以前一樣聚焦于單一模式,例如MT-NLG,而是致力于構建多模態模型。

5.人類反饋的強化學習的重要性:盡管人類反饋強化學習已出現多年,但還說不準它會對LLM的性能產生怎樣的影響。

我們推測,與GPT3相比,GPT4在初始訓練數據和強化學習數據增加的情況下,其性能將獲得跨越式提升。由于ChatGPT的普及,OpenAI為強化學習積累到了前所未有的海量數據。雖然初始訓練數據與強化學習的人類反饋數據之間的相對重要性還未可知,但我們認為,強化學習很有可能就是GPT-4的秘密武器。

6.擴展的重要性:如上所述,應用層公司可以收集相關的人類反饋進行強化學習。如果上面第五點關于人類反饋數據重要性的預測是正確的,那么擁有大量消費者的應用公司將能夠聚集海量專有、關鍵數據,以改進模型。

考慮到微軟與OpenAI的合作伙伴關系,在這場由AI主導的競賽中,其它媒體都認為微軟會是注定的贏家,但我們不能忽略Meta、谷歌、蘋果、亞馬遜、阿里巴巴和微信等公司,因為他們擁有大型面向客戶的應用程序。要記住,數據才是改進大型語言模型唯一真正有效的替代方案,因為模型規模和框架都可以被復制。

7.更多的公司將成為數據公司:因為訓練LLM需要大量的對話數據,所以那些能夠大規模收集此類數據的公司將受到高度重視。比如Twitter,它收集了最大的對話數據集之一。ChatGPT背后的模型就是在Twitter數據上進行訓練的,但ElonMusk知道后立即叫停了這類訓練。也許未來Twitter的大部分收入將來自于出售對話數據訪問權?Meta擁有Facebook、Instagram和Whatsapp,是另一家可以訪問大量對話數據的企業,試想一下,如果Meta的對話數據成為一項獨立業務,會產生多么大的價值呢?

8.公眾輿論和監管的焦點仍在于AI倫理及其社會影響:版權問題、模型可信度、勞工問題和網絡安全等話題已引發激烈辯論,甚至可能引起監管機構的注意。公司應謹慎應對監管環境。現在已經有許多法規示例即將出臺,例如歐盟AI法案和中國禁止創建無水印的AI生成媒體。目前的監管還處于不確定時期,在此之前,希望每個人都貢獻一份自己的力量,在AI應用中保持公平正義。

歡迎Star、試用OneFlow最新版本:https://github.com/Oneflow-Inc/oneflow/

1. 什么是比特幣NFT? 比特幣NFT——又名比特幣序數,又名數字文物——是一種在比特幣區塊鏈上刻寫數字內容的方式。CaseyRodarmor于2023年1月推出了比特幣序號協議.

1900/1/1 0:00:00受到人民幣匯率大幅反彈等因素的提振,A股在北上資金的助力下,各大指數節節攀升。1月16日,A股三大指數繼續走強,滬指重返3200點上方.

1900/1/1 0:00:00網通社從官方獲悉,領克01PHEV在以色列正式上市開售,價格約為22.99萬新謝克爾。這標志著領克品牌正式登陸以色列市場,同時也是領克首次在亞太地區銷售新能源車型,是對領克汽車全球品質的又一次驗.

1900/1/1 0:00:002023年3月19日,Libre中國區節點團隊的管理員Librearth應邀與廣大Libre礦工進行了一場生動的AMA,現將第一部分內容完整摘錄如下.

1900/1/1 0:00:00自數字人民幣試點再度擴圍以來,一直消息不斷,而其中覆蓋了各色場景的互聯網平臺,亦承擔著舉足輕重的角色.

1900/1/1 0:00:00背景去年5月曾經寫了一篇文章介紹了下LexFridman大佬的日常生活安排,后續我也根據他的方法對自己的日常生活做了一系列規范和改進.

1900/1/1 0:00:00